Tecnologia molecular promete desvendar a causa das doenças

Causalidade: a mãe de todas as intuições

Vemos o dia nascendo, o sol subindo, chegando a pino, depois descendo, até sumir, enquanto a noite toma forma. Esse ciclo fascina e serve de pano de fundo para o surgimento de várias percepções relevantes ao amadurecimento da mente infantil, como a de que o tempo do sono é o tempo de um ciclo natural que ocorre lá fora e de que o sol é responsável pelo calor e pela claridade.

O mesmo se dá em relação às coisas que jogamos para cima e que sabemos que cairão, a panela quente que sabemos que nos queimará e um sem fim de outras percepções estruturadas em torno de causas e efeitos, que aos 9 meses de idade já estão emitindo seus sinais, numa clara demonstração de como as pressões evolucionárias levam a concepções inatas sobre o funcionamento do mundo.

A descrição da causa das coisas é uma das forças por trás do avanço das formas de registro e comunicação, podendo ser observada em alguns dos nossos primeiros textos coerentes, mais de 4000 anos atrás. Descrições levam a versões e estas a disputas. Não tardou para o campo unificado da ciência e da filosofia ganhar a forma de uma espécie de arena para o duelo de concepções sobre as causas das coisas que mais nos importam, começando pela vida em si. Essa tensão gameficada que às vezes desanda em baixaria foi e permanece sendo determinante para o interesse pelo pensamento grego e por grande parte dos debates públicos durante séculos de produção intelectual.

A revolução científica iniciada com Galileu e estendida por Descarte e outros, a partir do início do século XVII, propôs descrever o mundo tal como se fosse uma grande e complexa máquina, com relações de causa e efeito por todos os lados, em substituição aos princípios da escolástica, que davam o tom até então.

Noam Chomsky costumava explicar isso com genial simplicidade, a partir de interpretações contrastantes sobre a percepção de um peão girando: na visão escolástica, a percepção aconteceria conforme o peão em si ressurgisse em nossa mente, por força de uma espécie de simpatia que nos uniria ao mesmo; na visão cartesiana, a experiência seria reconstruída, a partir de propriedades intrínsecas da mente, dispensando tal ligação mística. De um lado, o peão causa a percepção porque existe algo na natureza gerando este efeito; de outro, ele emerge da mente.

Em ambos os casos, chegamos do efeito percebido às causas, com convicção.

O mecanicismo de Galileu e Descartes sofreu abalos que o tornaram francamente obsoleto para explicar o mundo físico, já no começo do século XVIII, por meio da lei da gravitação universal de Isaac Newton e outras, que não dialogam bem com essa metáfora de geringonça universal.

Numa outra esfera, David Hume foi responsável por ressalvas importantes aos nossos juízos causais mais básicos. Causou furor, uma vez que estes juízos surgem da configuração que a evolução forjou para os nossos circuitos cerebrais.

Causalidade é a mãe das intuições.

O problema dos percalços causais pode parecer filosófico demais para interessar ao futuro da humanidade, mas a verdade é o contrário. Poucos problemas são tão importantes e servem tão bem de plataforma para a criação de soluções para os desafios de larga escala que enfrentamos hoje em dia e no futuro.

A questão sobre a qual me debrucei em meus dois últimos ensaios – como criar sistemas de suporte decisórios, baseados em inteligência artificial, adequados ao Estado – é todo permeado pela combinação da impossibilidade de rigorosamente irmos além das correlações, com a necessidade de tomarmos tais como se fossem causalidade, para podermos aplicar na prática aquilo que esses sistemas recomendam.

Na minha visão, o aprendizado de máquina (inteligência artificial dos softwares que ajudam as pessoas a tomarem decisões) é uma espécie de contraposição ao mecanicismo típico da computação tradicional, conforme exposto no ensaio "Um Nobel para Eliza".

Na atualidade, este braço central da evolução tecnológica da sociedade encontra-se atrelado a uma espécie de fase neo-humeniana, na qual o Graal é a causalidade, a capacidade de dizer que a combinação X de características gera Y.

O desafio causal não é exclusivo da inteligência artificial; muito pelo contrário, enquanto esta área ainda está tateando o assunto, na medicina, a discussão anda bem mais avançada.

É neste contexto que vem ganhando popularidade uma estratégia tecnológica que promete salvar vidas, limar tratamentos inúteis, poupar bilhões de dólares e acelerar o progresso da ciência substancialmente. Seu nome: randomização mendeliana.

O objetivo deste ensaio é explicar a randomização mendeliana, dando uma noção dos benefícios que pode nos trazer na prática. Após isso, despeço-me pela semana, com uma breve reflexão sobre causalidade e futuro, inspirada na mesma.

Princípios da randomização mendeliana

Não existe uma área rigorosamente dedicada às causas das doenças em geral; afinal, a complexidade de cada uma e a variância entre elas é suficientemente grande para que não tenhamos muitos cientistas com mais do que uma descrição causal no currículo. Apesar disso, um conceito especificamente talhado para a descrição do domínio das causas permanece popular no campo: etiologia.

Na prática, a teoria é outra e restringimos o uso do conceito às doenças individualmente consideradas, como em "a etiologia da esquizofrenia é multifatorial".

A estratégia consagrada tanto para a determinação da etiologia, quanto para o tratamento de uma doença é o ensaio clínico.

Por exemplo, a insuficiência ovariana prematura é uma condição em que a quantidade circundante de hormônio folicular estimulante (FSH) aumenta, levando mulheres à menopausa precoce. Até recentemente, cerca de 1/3 dos casos tinha sua causa elucidada. Para melhorar isso, um grupo liderado pelo pesquisador médico turco Begum Aydogan genotipou 200 mulheres, sendo metade portadora da condição e metade saudável, em busca de variantes genéticas (polimorfismos) associadas a mesma (https://bit.ly/2VGwIaJ).

A característica principal deste tipo de ensaio, que chamamos de observacional, é o fato de conhecermos de antemão o desfecho – insuficiência ovariana prematura –presente em um grupo, mas não em outro. A partir deste conhecimento, compilamos fatores moleculares que se destacam no time de quem tem a doença.

Evidentemente, não é possível ir além das correlações em estrito senso – ou seja, não se trata de desenho derradeiramente causal – e é preciso incluir muita gente para que as conclusões cheguem à prática clínica, afinal, a chance daquilo que foi correlacionado não ter papel causal na doença é considerável.

Um segundo tipo de experimento é o chamado ensaio clínico controlado e randomizado (RCT); este muitas vezes sucede o estudo observacional, na longa cadeia até a enunciação de uma hipótese etiológica séria ou um novo tratamento.

Por exemplo, autores de estudos observacionais sugeriram que betacaroteno protege contra câncer de pulmão. Isto levou a uma disparada na venda de suplementos, que não foi totalmente revertida quando RCTs mostraram que esse efeito inexiste.

O mote dos ensaios clínicos controlados e randomizados é contrapor procedimentos que achamos que possam funcionar a placebos. Os participantes devem ser distribuídos nos dois grupos (ativo/placebo) ao acaso e não devem saber em qual estão. Idealmente, esta informação não deve ser revelada para os próprios pesquisadores envolvidos na manipulação experimental (duplo-cego). Em nosso Lab (LinC-EPM-UNIFESP) priorizamos experimentos com este desenho.

Como é possível supor, avançar a medicina estritamente em cima da combinação entre estudos observacionais e RCTs é caro, muito trabalhoso e lento. Mesmo quem odeia a indústria farmacêutica com todas as suas forças não pode negar que um dos componentes que impacta o preço dos medicamentos é o alto custo das pesquisas que seguem o igualmente caro processo de síntese de uma nova molécula.

Agora, vamos considerar um novo ponto de vista: genes possuem as receitas para a síntese dos micro-blocos estruturais (aminoácidos) do organismo.

Genes frequentemente apresentam variantes na população (polimorfismos), as quais levam à formação de estruturas biológicas que diferem funcionalmente. As menos funcionais, muitas vezes, não chegam a impedir a geração de descendentes férteis, de modo que o polimorfismo se espalha. No exemplo acima, é fácil entender isso: mesmo que a menopausa seja antecipada em alguns anos, a maior parte das mulheres terá tempo suficiente para ter filhos, os quais levarão o polimorfismo à frente.

No plano molecular, as coisas se passam como se cada variante genética fosse uma mini-pessoa lutando por sua sobrevivência, num game que se desenrola sobre um grande escadão de pedra mal ajambrado, onde cada degrau é uma geração.

A intempestividade pode deslocar uma pedra e arrastar a si mesmo para o buraco.

Na escala que vai dos efeitos marginais à morte, essas variantes genéticas levam à produção de biomarcadores, que nos interessa saber se têm papel causal nas doenças, uma vez que conseguimos atuar sobre eles. Outras vezes, tais variantes genéticas mimetizam fatores ambientais, sem a maioria dos elementos de confusão que estes agregam à vida como ela é.

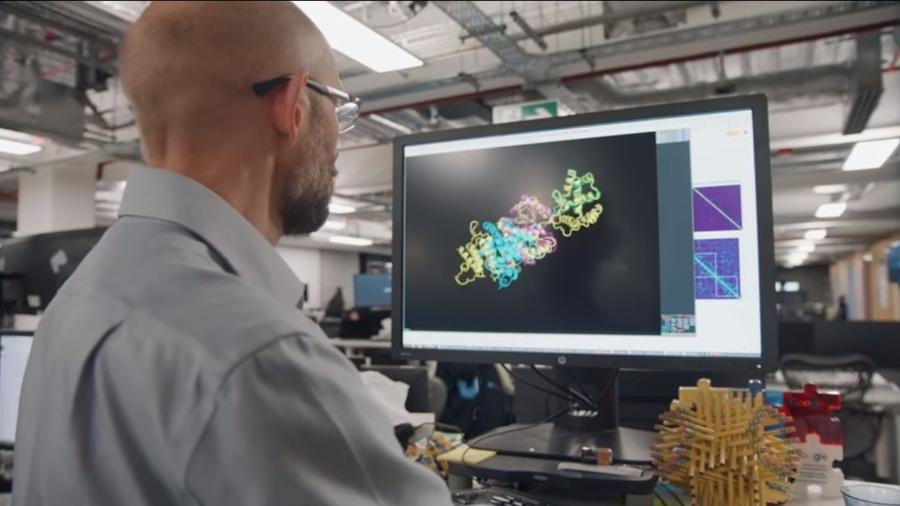

A proposta fundamental da randomização mendeliana é usar estes princípios para determinar a causa das doenças. Trata-se de uma alternativa poderosa aos ensaios clínicos tradicionais, que reflete o rápido avanço das tecnologias moleculares.

Há alguns anos, isso poderia soar como a ideia mais insensata que alguém poderia ter. Mas, fato é que as bases de dados genéticos estão se tornando gigantescas e o custo de fazer um estudo desses cada vez mais se aproxima do custo de rodar algumas análises. Esse é o aspecto mais revolucionário de todos, o qual transcende a especificidade da discussão. A medicina vem se tornando cada vez mais tecnológica e molecular, através de mudanças de paradigmas que atingem seus aspectos mais elementares.

Olhemos a prática. Muito se discute sobre o papel do álcool nas doenças cardiovasculares. De um lado, há a hipótese de que o álcool aumente o risco das mesmas, mas como quem bebe mais tende a fumar, as conclusões acabam prejudicadas. De outro lado, reside a hipótese contrária, a qual não deixa de viver seus próprios dramas, sobretudo em função de um problema metodológico chamado reversão causal: o sujeito que sofre de doenças cardiovasculares costuma beber menos, dado que sua vida se torna generalizadamente mais regrada.

Parece simples corrigir esses fatores de confusão, mas a realidade é oposta.

Os estudos empíricos vão crescendo internamente e se multiplicando, o tempo vai passando, a discussão se arrasta e até hoje as pessoas não sabem muito bem se devem beber para se proteger um pouco das doenças cardiovasculares e, ainda mais, o quanto devem fazê-lo, em caso afirmativo.

Como sair desse impasse? Uma coisa que se sabe é que os efeitos do álcool ganham forma por vias moleculares relacionadas a sua transformação em acetato (oxidação). Portadores de uma variante do gene ALDH2 têm mais dificuldade em fazer isso, o que vem acompanhado de uma série de reações negativas ao consumo elevado de birita. Como consequência, tendem a beber pouco.

Ficam vermelhos como pimentão e, na segunda taça, passam mal. Quem nunca viu?

Portanto, para saber qual o papel do álcool nessa história, acaba sendo melhor responder se os portadores do perfil genético que induz baixo consumo têm +/- doenças cardiovasculares, do que adotar o caminho aparentemente mais intuitivo, investigando a relação entre o consumo em si e a presença destas doenças.

Agora vamos dar um passo a mais em sentido ao aspecto mais profundo da randomização mendeliana. Para tanto, consideremos o fato de que o chamado colesterol bom (HDL) é inversamente relacionado à doença coronária arterial (CAD).

Sob tal princípio, muitas vezes foi dito que o efeito protetivo do álcool no organismo ocorre por essa via. O estudo mencionado acima é taxativo: "o efeito cardio-protetivo do álcool é mediado pelo aumento no HDL".

Acontece que pela aplicação de randomização mendeliana foi verificado que as variantes genéticas que aumentam o HDL não diminuem a frequência de infartos do miocárdio e doenças associadas (https://bit.ly/2JS5DyJ e https://bit.ly/2HtwxLQ). Ou seja, o estudo citado está errado e a gente pode dizer com segurança que o HDL não é fator causal (direto/inverso), a despeito de todas as aparências.

Beber moderadamente tende a ter efeitos protetivos (https://bit.ly/2wvCrFB), mas isso não ocorre em função do HDL, ainda que este de fato aumente em quem bebe quantidades pequenas e medianas, com constância.

A mensagem que segue e que serve de medida da relevância dessa novo tipo de estudo molecular é que terapias para aumentar o HDL são perda de tempo.

Causas distais e o futuro das tecnologias moleculares

As causas, no domínio da vida, desdobram-se em planos distintos, de acordo com a escala temporal na qual consideramos um fenômeno natural.

Por exemplo, o comportamento de beber água pode ter como causa uma experiência desagradável (sede), que procuramos aplacar. Esta tem como sua própria causa a atividade de um sistema cerebral formado pela amina terminalis, núcleo pré-optico e outros, que infere a concentração osmótica do organismo. A atividade deste sistema é causada pela expressão de genes, o que envolve DNA, RNA, metilações e muito mais.

Todo esse ecossistema de relações pode ser chamado de domínio das causas proximais. O que lhe caracteriza é o fato destas causas estarem no mesmo plano existencial da pessoa que efetivamente bebe a água.

Hume não poderia imaginar, mas existe um outro plano. Este é o das causas distais. Ninguém pode acessá-lo diretamente, mas ele serve de substrato às próprias causas proximais, dos genes ao comportamento.

No plano das causas distais residem as pressões seletivas e outros fatores evolucionários responsáveis por estes genes específicos terem chegado até aqui e não outros quaisquer. Não tome esta ideia como meramente filosófica, a coisa vai além.

Cada vez mais, torna-se claro que as mais intrincadas estruturas da natureza são criadas replicando princípios da evolução por seleção natural, no interior de cada organismo. Princípios distais manifestam-se em ambientes proximais.

Hoje sabemos que uma das razões para termos quase cem bilhões de neurônios e, ainda assim, não sofrermos com uma profusão de defeitos incapacitantes é o fato destas células competirem por recursos neurotróficos (comida de neurônio) durante o período em que nosso cérebro está se desenvolvendo.

Os neurônios menos aptos dançam no caminho, mais ou menos como alguns de seus ancestrais menos adaptados.

Este tipo de princípio vem sendo largamente aplicado no desenvolvimento de terapêuticas oncológicas e outras mais. Fora da medicina, passou a dar o tom para quem quer empreender no estilo do Vale do Silício (die fast) ou simplesmente lançar um produto (MVP).

O ethos do mundo está mais darwiniano do que nunca, a despeito do fato de sabermos que, em nível molecular, a evolução não é tão darwiniana quanto assumem os biólogos mais ortodoxos.

Porém, para além disso tudo, existe uma coisa nova no pedaço, que é a possibilidade de alterarmos nossos próprios genes, transmitindo essas alterações para as próximas gerações. Isto é tal como se a escadaria geracional que atravessamos nos últimos cem mil anos ficasse em outro planeta. Falaremos disso um pouco mais para frente.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.